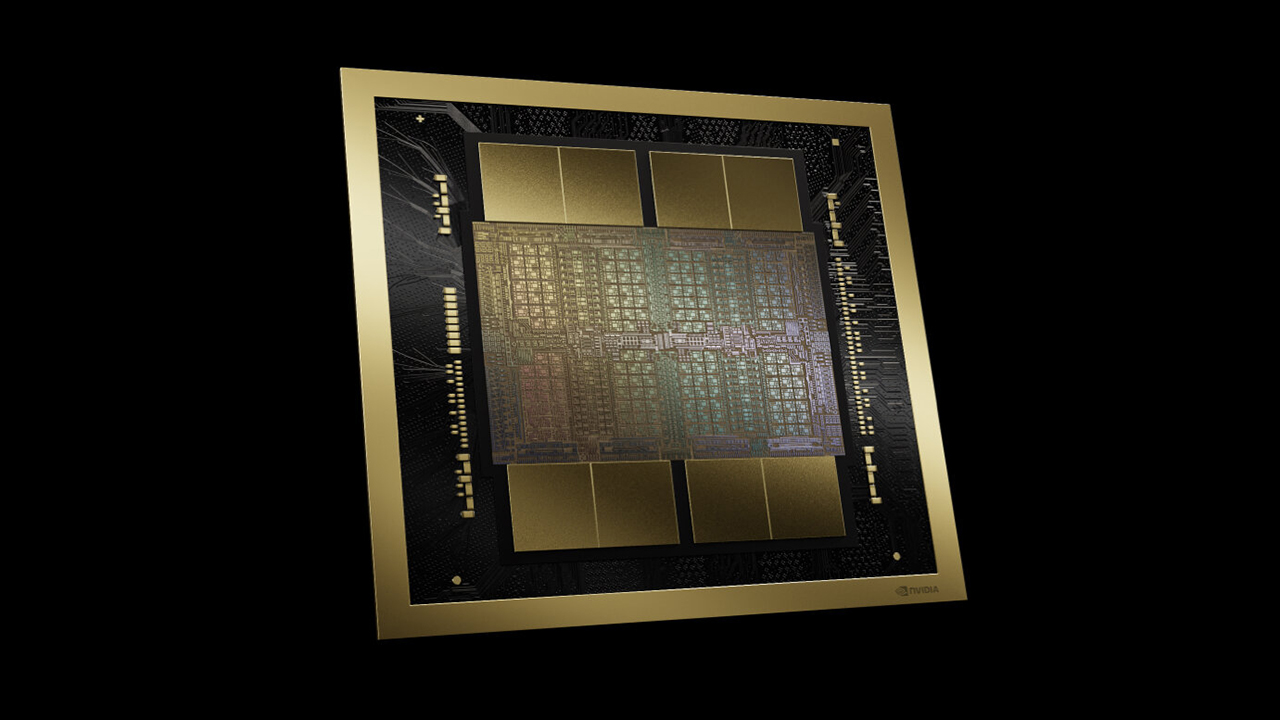

L’irrinunciabile chip di intelligenza artificiale H100 di Nvidia l’ha resa un’azienda da miliardi di dollari, che potrebbe valere più di Alphabet e Amazon, e i concorrenti hanno lottato per raggiungerla. Ma forse Nvidia sta per estendere il suo vantaggio, con la nuova GPU Blackwell B200 e il “superchip” GB200. Nvidia afferma che la nuova GPU B200 offre fino a 20 petaflop di potenza FP4 grazie ai suoi 208 miliardi di transistor. Inoltre, un GB200 che combina due di queste GPU con una singola CPU Grace può offrire prestazioni 30 volte superiori per i carichi di lavoro di inferenza LLM, oltre a essere potenzialmente molto più efficiente. Secondo Nvidia, “riduce i costi e il consumo energetico fino a 25 volte” rispetto a un H100. Secondo Nvidia, l’addestramento di un modello da 1,8 trilioni di parametri avrebbe richiesto in precedenza 8.000 GPU Hopper e 15 megawatt di potenza. Oggi, il CEO di Nvidia afferma che 2.000 GPU Blackwell possono farlo consumando solo quattro megawatt.

Su un benchmark GPT-3 LLM con 175 miliardi di parametri, Nvidia afferma che il GB200 ha prestazioni sette volte superiori a quelle di un H100 e che offre una velocità di addestramento quattro volte superiore. Nvidia ha dichiarato ai giornalisti che uno dei miglioramenti principali è un motore di trasformazione di seconda generazione che raddoppia il calcolo, la larghezza di banda e le dimensioni del modello utilizzando quattro bit per ogni neurone invece di otto (quindi i 20 petaflop di FP4 di cui ho parlato prima). Una seconda differenza fondamentale si ottiene solo quando si collega un numero enorme di queste GPU: uno switch NVLink di nuova generazione che consente a 576 GPU di parlare tra loro, con 1,8 terabyte al secondo di larghezza di banda bidirezionale.

Ciò ha richiesto a Nvidia la costruzione di un intero nuovo chip per lo switch di rete, dotato di 50 miliardi di transistor e di una parte dell’elaborazione interna: 3,6 teraflops di FP8, secondo Nvidia. In precedenza, secondo Nvidia, un cluster di sole 16 GPU passava il 60% del tempo a comunicare tra loro e solo il 40% ad elaborare. L’azienda conta ovviamente sul fatto che le aziende acquistino grandi quantità di queste GPU e le sta confezionando in progetti più grandi, come il GB200 NVL72, che inserisce 36 CPU e 72 GPU in un singolo rack raffreddato a liquido per un totale di 720 petaflop di prestazioni di addestramento dell’intelligenza artificiale o 1.440 petaflop (alias 1,4 exaflop) di inferenza. Al suo interno sono presenti quasi tre chilometri di cavi, con 5.000 cavi singoli.