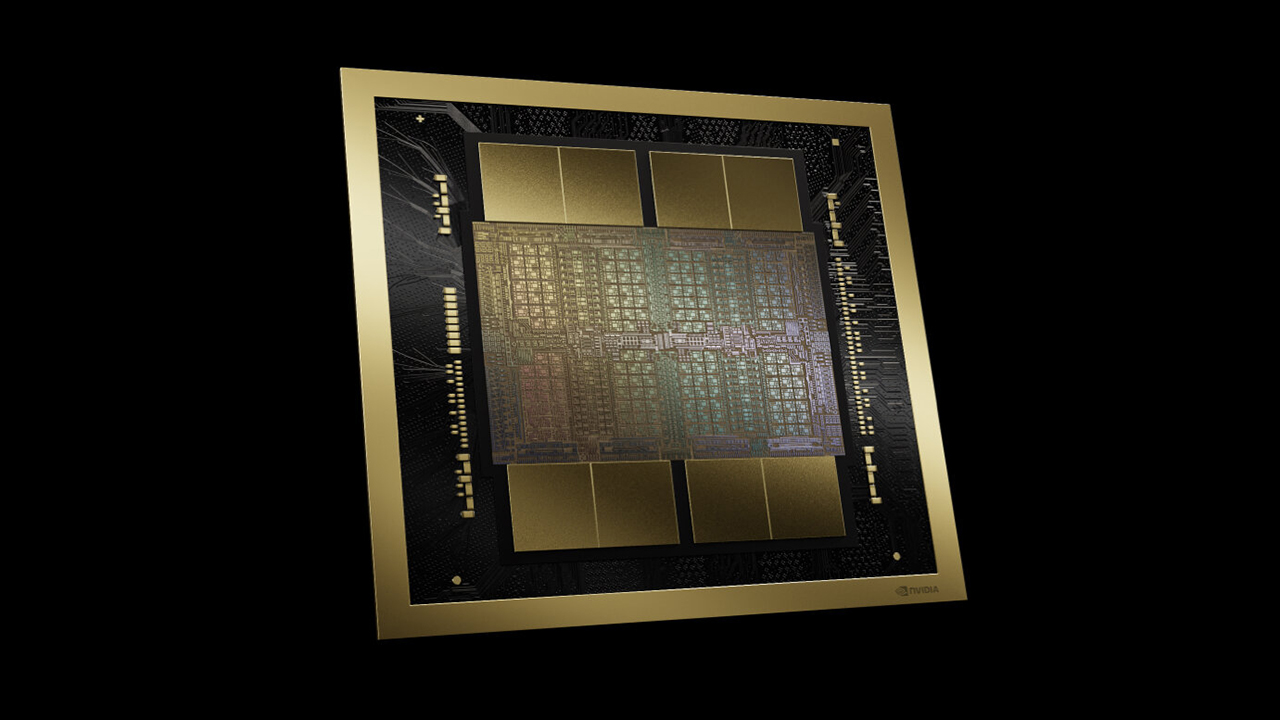

Secondo quanto annunciato recentemente, le funzioni di intelligenza artificiale generativa sotto la bandiera di Apple Intelligence si sono tenute lontane dallo sfruttare le GPU NVIDIA per gestire gli input basati su cloud, con il gigante californiano che si è attenuto al silicio personalizzato nei suoi server, che alla fine sarà sostituito dall’inedito M4 Ultra, per accelerare i suoi Large Language Models. Tuttavia, un recente post sul blog del produttore di iPhone rivela che Apple e i suoi ingegneri non si tirano indietro di fronte alla possibilità di collaborare con NVIDIA se ciò significa che entrambe le compagnie hanno un obiettivo comune: implementare prestazioni più rapide nella generazione di testo con gli LLM.

Ecco cosa è stato dichiarato in merito alla questione:

Questo lavoro di ricerca ha dimostrato ottimi risultati, ma il suo maggiore impatto deriva dall’applicazione in produzione per accelerare l’inferenza LLM. Per rendere questo progresso pronto per la produzione per le GPU NVIDIA, abbiamo collaborato con NVIDIA per integrare ReDrafter nel framework di accelerazione dell’inferenza NVIDIA TensorRT-LLM.

Sebbene TensorRT-LLM supporti numerosi LLM open source e il metodo di decodifica speculativa Medusa, gli algoritmi di ricerca del fascio e di attenzione ad albero di ReDrafter si basano su operatori che non sono mai stati utilizzati in applicazioni precedenti. Per consentire l’integrazione di ReDrafter, NVIDIA ha aggiunto nuovi operatori o esposto quelli esistenti, migliorando notevolmente la capacità di TensorRT-LLM di accogliere modelli e metodi di decodifica sofisticati. Gli sviluppatori di ML che utilizzano le GPU NVIDIA possono ora beneficiare facilmente della generazione accelerata di token di ReDrafter per le loro applicazioni LLM di produzione con TensorRT-LLM.

Nel benchmark di un modello di produzione da decine di miliardi di parametri su GPU NVIDIA, utilizzando il framework di accelerazione dell’inferenza NVIDIA TensorRT-LLM con ReDrafter, abbiamo riscontrato un aumento di 2,7 volte della velocità dei token generati al secondo per la decodifica greedy. I risultati dei benchmark indicano che questa tecnologia potrebbe ridurre in modo significativo la latenza che gli utenti potrebbero sperimentare, oltre a utilizzare un numero inferiore di GPU e a consumare meno energia.

Clicca sulla copertina per leggere